50 Jahre Klimaforschung am Max-Planck-Institut für Meteorologie

Vor den Tiefen des Weltalls, komplett von der Sonne angeleuchtet, zeigte sich die Erde den Astronauten der Apollo-17-Mission am 7. Dezember 1972 in ihrer ganzen Schönheit: Das intensive Blau des Ozeans, die erdigen Brauntöne der Landmassen, das strahlende Weiß des antarktischen Eisschilds und die dynamische Struktur spiralförmiger und federartiger Wolkenformationen charakterisieren das Bild des blauen Planeten. Das damals aufgenommene Foto der sogenannten „Blue Marble“ („blauen Murmel“) passte zum Zeitgeist der beginnenden 1970er-Jahre. Es wurde zu einem der meistverbreiteten Bilder der Menschheitsgeschichte und avancierte in den Anfängen der Umweltbewegung zum Sinnbild der Einzigartigkeit, aber auch der Verletzlichkeit der Erde.

In diese Zeit fiel nicht zufällig die Gründung des Max-Planck-Instituts für Meteorologie (MPI-M). Die Sorge im Hinblick auf die ökologische Belastbarkeit der Erde und die Vermutung, die Menschen könnten durch den Ausstoß von Kohlendioxid das Klima beeinflussen, waren in der Öffentlichkeit Thema. Die Forschung in Deutschland stand unter Zugzwang, denn sie hinkte im internationalen Vergleich etwa ein Jahrzehnt hinterher.

Den Anfang machen Atmosphäre und Ozean

Die Max-Planck-Gesellschaft hatte sich vor diesem Hintergrund die Gründung eines Klimaforschungsinstituts vorgenommen. Die Wahl fiel auf Hamburg, da sich dort die Gelegenheit bot, Teile des renommierten Fraunhofer-Instituts für Radiometeorologie und Maritime Meteorologie in das MPI-M zu übernehmen. Als Gründungsdirektor wurde der Physiker und Mathematiker Klaus Hasselmann berufen. Bei der Eröffnung des MPI-M am 5. Dezember 1975 sagte er, der Name des Instituts sei dem Umstand geschuldet, dass es keine griffige deutsche Übersetzung für den englischen Ausdruck ‚atmosphere-ocean physics‘ gäbe. Denn der Plan für das MPI-M war nicht, klassische Wetterkunde zu betreiben, sondern das Klima der Erde zu verstehen. Dieses Vorhaben musste früher oder später aber auch über die Betrachtung von Atmosphäre und Ozean hinausgehen, wie Hasselmann darlegte: „(…) man muss noch weitere wichtige Komponenten in ein vollständiges klimatisches System einbeziehen, z.B. die Biosphäre, (…) oder die verschiedenen chemischen Wechselwirkungen im Kreislauf der Spurenstoffe und Aerosole, die den Strahlenhaushalt der Atmosphäre mitbestimmen, und noch viele andere Prozesse.“

Doch zunächst widmete sich das Institut den beiden Hauptkomponenten des Klimasystems, die auch prominent aus der Aufnahme des blauen Planeten hervorstechen: der Ozean und – auf dem Foto in Gestalt der Wolken – die Atmosphäre. Hasselmann baute seine Abteilung zur „Physik des Meeres und Klimadynamik“ neu auf, während die zweite Abteilung zur „Physik der Atmosphäre“, geleitet von dem Meteorologen Hans Hinzpeter, anfangs aus Mitarbeitenden des ehemaligen Fraunhofer-Instituts bestand. Hinzpeter erforschte Austauschprozesse zwischen der Atmosphäre und dem Ozean sowie die Interaktion von Wolken, Aerosolen, Wasserdampf und Strahlung. Er führte dazu Beobachtungen durch, analysierte Messdaten und entwickelte Geräte, mit denen sich die Eigenschaften der Atmosphäre aus der Ferne vermessen ließen.

Die Bedingung der Möglichkeit von Klimamodellierung

Hasselmann befasste sich anfangs mit grundsätzlichen Fragen: Sind die beobachteten Klimaschwankungen überhaupt deterministisch, also im Grundsatz berechenbar, oder sind sie zufällig? Und wie lässt sich unterscheiden, welche Klimaänderungen natürlichen Ursprungs und welche vom Menschen verursacht sind? Er behandelte das Wetter als natürliche Unruhe im Klimasystem und zeigte, dass dieses angenommene zufällige Rauschen aufgrund der Trägheit des Ozeans längerfristige Schwankungen im Klimasystem erzeugt.

Ein wichtiges Ergebnis dieser Untersuchungen war, dass eine Unterscheidung zwischen natürlicher Variabilität und äußeren Einflüssen möglich ist. Wie genau sich das mathematisch bewerkstelligen ließe, dafür entwarf Hasselmann schon 1979 ein Konzept. Bis er diese Methode mithilfe von fortgeschrittenen Klimamodellen anwenden konnte, dauerte es aufgrund der eingeschränkten Rechenkapazitäten aber noch bis in die Neunzigerjahre.

Erste Zirkulationsmodelle des Ozeans

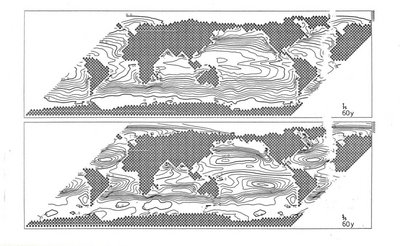

Parallel zu Hinzpeters beobachtender Forschung und zu Hasselmanns theoretischen Grundsatzüberlegungen etablierte Hasselmann auch die Modellierung am MPI-M. Dieser wissenschaftliche Blick auf den blauen Planeten erfordert eine Einteilung oder Diskretisierung der Atmosphäre, des Ozeans und anderer Komponenten. Das lässt sich erreichen, indem man ein Gitter über die Erdoberfläche legt, welches sich auch durch die Höhe der Atmosphäre und die Tiefe des Ozeans oder der Landoberfläche erstreckt. Die über die resultierenden dreidimensionalen Gitterelemente gemittelten Werte definieren dann den Zustand des Systems. Mithilfe physikalischer Gesetze und Hilfsannahmen wird er zeitlich fortentwickelt.

Solch ein dreidimensionales Modell erarbeitete der Physiker Ernst Maier-Reimer am MPI-M für den Ozean. Das Ergebnis war herausragend: Das großskalig-geostrophische Ozeanzirkulationsmodell (Large-Scale Geostrophic Ocean General Circulation Model, LSG) galt als das schnellste dynamische globale Ozeanmodell aller Zeiten. Angesichts damals noch stark begrenzter Rechenkapazitäten war das ein großer Vorteil, insbesondere bei der Untersuchung von Prozessen auf langen Zeitskalen. Maier-Reimer baute früh eine Kohlenstoffchemie in das Modell ein. Über die Integration von Nährstoffen wurden auch biogeochemische Prozesse erstmals dargestellt, woraus das „Hamburg Ocean Carbon Cycle“-Modell (HAMOCC) entstand. Diese Pionierarbeit war ihrer Zeit weit voraus. Sie schaffte die Grundlage für viele Studien zum Kohlenstoffkreislauf im Ozean und half die Frage zu beantworten, wie viel Kohlendioxid, das durch menschliche Aktivitäten freigesetzt wird, vom Ozean absorbiert wird und wie viel in der Atmosphäre verbleibt und dort für eine zusätzliche Erwärmung sorgt.

Gekoppelte Modelle und steigende Rechenkapazitäten

Neben dem LSG-Modell gab es mit dem isopyknischen Ozeanmodell OPYC ein alternatives Ozeanzirkulationsmodell, das Josef Oberhuber entwickelte. Maier-Reimer legte außerdem mit dem Hamburg Ocean Primitive Equation Model (HOPE) ein weiteres Modell vor, das zunächst hauptsächlich auf den tropischen Pazifik angewendet wurde. Erste Versuche, die Ozeanmodelle des MPI-M mit dem Atmosphärenmodell des Europäischen Zentrums für mittelfristige Wettervorhersage (ECMWF) zu koppeln, gelangen Ende der Achtzigerjahre.

Ermöglicht und beflügelt wurden die Fortschritte in der Modellierung durch den Ausbau der Rechenkapazitäten vor Ort, für den Hasselmann wiederholt bei Geldgebern warb. Rückenwind erhielt er durch das 1982 etablierte Klimaforschungsprogramm der Bundesregierung. So erhielt Hamburg Mitte der Achtzigerjahre seinen ersten Supercomputer. 1987 gründeten die Max-Planck-Gesellschaft, die Freie und Hansestadt Hamburg sowie das GKSS-Forschungszentrum in Geesthacht (heute Helmholtz-Zentrum Hereon) gemeinsam das Deutsche Klimarechenzentrum (DKRZ) als Serviceeinrichtung für die Klimaforschung in ganz Deutschland. Konnte man auf dem Vorgänger mit gekoppelten Modellen nur zwei Jahre in die Zukunft rechnen, so waren es mit dem 1988 angeschafften Supercomputer Cray-2S schon 100 Jahre. Dies illustriert, wie die Verfügbarkeit immer leistungsfähigerer Computer die Vorreiterrolle des MPI-M bei der Klimamodellierung ermöglichte – und bis heute ermöglicht.

Neue Personen, neue Impulse

Neben dem Ausbau der Rechenkapazitäten spielten auch personelle Veränderungen in der Leitung eine Rolle dafür, wie sich die Klimaforschung am MPI-M entwickelte. Der Nachfolger Hans Hinzpeters, Hartmut Graßl, verfügte über Expertise in der bodengebundenen und satellitengestützten Fernerkundung. Mit den Satelliten war seit den 1970er-Jahren eine Möglichkeit entstanden, den blauen Planeten dauerhaft aus der Ferne zu vermessen. Graßl setzte damit die beobachtende Forschung Hinzpeters, die in enger Zusammenarbeit mit der Universität Hamburg erfolgt war, in ebenso erfolgreicher Kooperation fort.

Außerdem konnte das MPI-M 1991 den ehemaligen Direktor des ECMWF, Lennart Bengtsson, gewinnen für eine dritte Abteilung zur „Theoretischen Klimamodellierung“. Bengtsson stellte Erich Roeckner ein, der zuvor an der Uni Hamburg tätig und ein Experte für Planetenatmosphären war. Dieser hatte bereits begonnen, das numerische Wettervorhersagemodell des ECMWF in ein Klimamodell umzuwandeln. Das bedeutet, dass damit längere Zeiträume berechnet werden mussten, was bei unveränderten Rechenkapazitäten nur durch eine Verringerung der räumlichen Auflösung möglich war. Das Modell erhielt den Namen ECHAM – wobei die ersten beiden Buchstaben für die Herkunft des Modells (ECMWF) und die letzten drei für Hamburg stehen.

Klimastudien und Szenarienrechnungen

ECHAM wurde erfolgreich mit allen drei Ozeanmodellen gekoppelt. Mit dem ECHAM/LSG-Modell ermittelte eine Gruppe um Stephan Bakan Anfang der Neunzigerjahre, wie sich die Brände von Ölfeldern in Kuwait nach Ende des Golfkrieges auf das Klima auswirken würden. Mojib Latif und Kolleg*innen führten mit ECHAM/HOPE Studien zum Wetterphänomen El Niño durch. Und mit ECHAM/OPYC ließ sich beispielsweise die Nordatlantik-Zirkulation untersuchen. Langfristig setzte sich die Kombination ECHAM/HOPE durch, und aus HOPE wurde das MPI-Ozeanmodell (MPI-OM).

Die gekoppelten Atmosphäre-Ozean-Modelle erlaubten auch zu berechnen, wie sich das Klima unter verschiedenen Szenarien des 1988 gegründeten Weltklimarates (Intergovernmental Panel on Climate Change, IPCC) hinsichtlich zukünftiger Treibhausgasemissionen entwickeln würde. Die Berechnungen fanden Einzug in den 1992 veröffentlichten Anhang zum ersten Sachstandsbericht des IPCC – und fortan in alle weiteren bis zum sechsten Sachstandsbericht von 2021, seit 1995 als Teil des Coupled Model Intercomparison Project (CMIP). Die Modelle verhalfen dem MPI-M zu internationaler Beachtung. In einem internen Papier des amerikanischen National Center for Atmospheric Research (NCAR) hieß es 1995, die Nummer Eins in der Klimamodellierung seien nicht länger die USA, sondern Deutschland.

Zu dieser Vorreiterrolle trug auch der Nachweis bei, dass der Mensch die „Blue Marble“ durch seine Aktivitäten verändert. Eine Gruppe um Gabi Hegerl wandte die 1979 von Hasselmann entwickelte Methode auf die gekoppelten Modelle an. Die Wissenschaftler*innen verglichen Klimasimulationen, die den Einfluss des Menschen berücksichtigten, mit solchen, die das nicht tun, und zeigten: Die Wahrscheinlichkeit, dass der beobachtete Temperaturanstieg allein natürlichen Faktoren zuzuordnen sei, liege unter fünf Prozent. Heute ist der Wert noch geringer. Für diese „Fingerabdruck“-Methode erhielt Klaus Hasselmann im Jahr 2021 zusammen mit Syukuro Manabe eine Hälfte des Nobelpreises für Physik, die andere Hälfte ging an den italienischen Physiker Giorgio Parisi.

Ein neuer Weg vorwärts

Zwar war die Fingerabdruck-Studie ein Paukenschlag in einer Zeit, als international die Klimaverhandlungen an Fahrt aufnahmen: 1992 wurde im brasilianischen Rio de Janeiro die Klimarahmenkonvention der Vereinten Nationen (United Nations, UN) vereinbart, 1995 trafen sich die Vertragsstaaten erstmals zur UN-Klimakonferenz, die seither jährlich stattfindet. Doch das MPI-M profitierte von diesem Schwung zunächst nicht. Im Gegenteil: Mit der bevorstehenden Emeritierung von Bengtsson und Hasselmann sowie der Abwesenheit Graßls, der für die Tätigkeit als Direktor des Weltklimaforschungsprogramms in Genf beurlaubt war, stand die Zukunft des Instituts infrage. Denn die MPG war im Nachgang der deutschen Wiedervereinigung ohnehin in einer schwierigen Finanzlage. Zwischendurch schien trotz aller Erfolge und des internationalen Renommees sogar die Schließung des MPI-M nicht ausgeschlossen. Erst durch die frühzeitige Rückkehr Graßls aus Genf und die Klärung der Nachfolge Hasselmanns konnte das Institut die Krise überwinden.

Mit der Zusage, die Rechenkapazitäten weiter auszubauen, war es gelungen, den Atmosphärenchemiker Guy Brasseur vom NCAR zum 1. Oktober 1999 als neuen Direktor am MPI-M zu gewinnen. So erhielten biogeochemische Prozesse und Aerosole verstärkt Einzug in die am MPI-M entwickelten Modelle. Während Brasseurs Fokus auf der Atmosphäre lag, belebte der Nachfolger Bengtssons, Jochem Marotzke vom Southampton Oceanography Centre im Vereinigten Königreich, die Ozeanforschung neu und untersuchte Quellen der Vorhersagbarkeit, die in der langsamen Entwicklung des Ozeans verwurzelt sind. Er initiierte hierzu ein Projekt, das langfristig in ein Modell mündete, mit dem der Deutsche Wetterdienst (DWD) seit 2020 dekadische Vorhersagen bereitstellt.

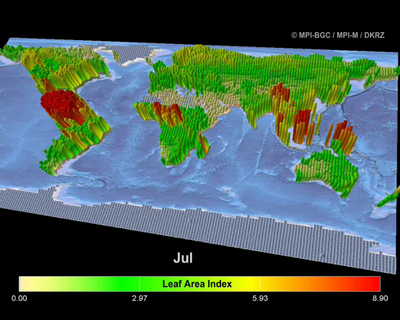

Atmosphäre, Ozean, Land: Der Dreiklang des Erdsystems

Gemessen an Hasselmanns Aufzählung bei der Eröffnung des MPI-M fehlte zu einer vollumfänglichen Betrachtung des Erdsystems noch eine biologisch aktive Landoberfläche: die Vegetation und die Böden, welche durch ihre Struktur den Energie- und Impulsaustausch beeinflussen, und welche essentiell für den Kohlenstoffkreislauf sind. Aus dem 1997 gegründeten MPI für Biogeochemie in Jena kam deswegen 2001 eine Gruppe von Wissenschaftler*innen nach Hamburg, um die Landbiosphäre in ECHAM zu integrieren. Zunächst als „Green ECHAM“ bezeichnet, erhielt das Biosphärenmodell bald den Namen JSBACH (Jena Scheme for Biosphere-Atmosphere Coupling in Hamburg), in Anklang an das Atmosphärenchemie-Modell MOZART, das Brasseur entwickelt und nach Hamburg mitgebracht hatte.

Der Nachfolger Hartmut Graßls, Martin Claußen – zuvor stellvertretender Direktor des Potsdam-Instituts für Klimafolgenforschung –, übernahm die Jenaer Gruppe 2005 in seine Abteilung. Sein Interesse galt der Wechselwirkung zwischen der Landoberfläche, der Vegetation und der Atmosphäre, seine Abteilung am MPI-M nannte sich demnach „Land im Erdsystem“. Damit vollzog sich der Übergang von der Atmosphäre-Ozean-Modellierung zur umfassenderen Erdsystembetrachtung.

Im Jahr 2008 trat Bjorn Stevens die Nachfolge Brasseurs an. Stevens, der zuvor Professor für Meteorologie an der University of California in Los Angeles gewesen war, erforschte die Physik der Atmosphäre – sowohl mit Modellen als auch durch Beobachtungen. Diese Interessen passten gut zum MPI-M, wo er auf den Modellierungsarbeiten von Bengtsson und Roeckner und den Fortschritten Hinzpeters und Graßls bei den Beobachtungen aufbauen konnte. So errichtete er 2010 mit Partnern aus Barbados auf der Atlantikinsel ein Wolkenobservatorium und nutzte ab 2013 in Kooperation mit der Uni Hamburg intensiv das Forschungsflugzeug HALO für Beobachtungen von Wolken und der atmosphärischen Zirkulation, um Ideen zu überprüfen, die aus den am Institut und weltweit entwickelten Modellen hervorgingen.

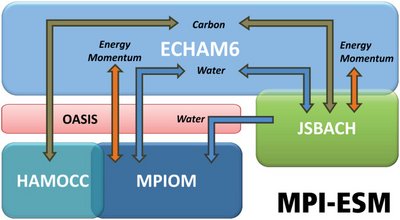

Die zahlreichen Modellentwicklungen für die verschiedenen Komponenten des Erdsystems – ECHAM, HOPE/MPI-OM, HAMOCC, JSBACH, MOZART – griffen nun ineinander und ließen sich in einem gemeinsamen, umfassenden Modell vereinen. Mit dem MPI-ESM genannten gekoppelten Erdsystemmodell hatte sich das Institut ein leistungsfähiges Werkzeug erarbeitet. Das Modell und die Ideen, die aus seiner Nutzung hervorgingen, beeinflussten nicht nur viele Klimaberichte und das öffentliche Bewusstsein für den Klimawandel, sondern wurden auch für Studien zur Klimageschichte des Planeten verwendet. So untersuchte das Institut unter der Federführung von Johann Jungclaus im Rahmen des sogenannten Millennium-Projekts die Schwankungen des Klimas über einen Zeitraum von 1200 Jahren. Es war die erste Demonstration der Mächtigkeit des MPI-ESM: Die Forschenden gaben im Wesentlichen nur externe Antriebe vor – zum Beispiel die Sonnenaktivität, Erdbahnparameter, Treibhausgas-Emissionen, Landnutzung und Vulkanausbrüche. Den Rest erledigten die Physik und die biogeochemischen Prozesse im Modell. Damit hatte sich das MPI-M einen Spitzenplatz in der Erdsystemmodellierung gesichert.

Ein Umbruch in der Modellierung

An verschiedenen Stellen geriet das Arbeitspferd des MPI jedoch auch an Grenzen. Zum einen erforderte die Chemie eine Art von mathematischen Formulierungen, für die ECHAM nicht ausgelegt war. Zum anderen schien es, als könne ECHAM die parallele Rechnerstruktur moderner Supercomputer nicht effizient nutzen.

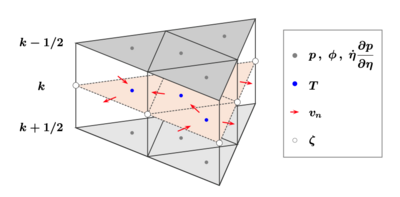

Und dann gab es da noch die Form des Gitters. Die bis dahin genutzte Aufteilung nach Längen- und Breitengraden hatte einen Nachteil: Da die Längengrade an den Polen zusammenlaufen, wurden dort die Gitterzellen immer kleiner. Das verursachte mathematische Probleme, sodass die Wissenschaftler*innen Nord- und Südpol immer als Sonderfälle handhaben mussten. Gesucht war demnach ein Gitter, dessen Zellen überall auf der Erde gleichgroß sind – ein aus vielen gleichartigen Flächen bestehender Körper mit größtmöglicher Symmetrie. Dieses Kriterium erfüllen sogenannte platonische Körper, von denen es fünf Arten gibt – darunter der Ikosaeder mit 20 gleichseitigen Dreiecken.

Konnte es gelingen, diesen platonischen Körper als Grundlage für ein neues Gitter und damit für ein neues Klimamodell zu nutzen? Der von Brasseur eingestellte Mathematiker Luca Bonaventura untersuchte diese Fragestellung mit einem stark vereinfachten zweidimensionalen Modell und erzielte ermutigende Ergebnisse. Ein von Grund auf neues und anderes Klimamodell zu entwerfen, war allerdings eine komplexe Aufgabe, die innovative Ideen und einen langen Atem erforderte. Der mögliche wissenschaftliche Gewinn war aber vielversprechend, und so entschieden die Direktoren Stevens, Marotzke und Claußen, die Entwicklung des neuen Modells gemeinsam mit dem DWD voranzutreiben. Doch nicht nur das Gitter war neu, sondern auch die Art der Gleichungen. Das Modell erhielt deshalb den Namen ICON (icosahedral non‐hydrostatic).

Ein neues Erdsystemmodell

Die wissenschaftliche Gemeinschaft war zunächst skeptisch: Das Dreiecksgitter hatte die Eigenart, in dreidimensionalen Modellen „falsche“ Lösungen der Modellgleichungen zu begünstigen. Durch kreative Rechenverfahren konnte eine Gruppe um Peter Korn dieses Problem für die Ozeankomponente von ICON lösen. In enger Zusammenarbeit mit Wissenschaftler*innen des DWD setzte ein von Marco Giorgetta geleitetes Team andere Methoden ein, um diese Probleme in der Atmosphäre zu aufzufangen. Sie übertrugen die Kunstfertigkeit von Roeckners ECHAM erfolgreich auf die neuen Gleichungen und das Gitter von ICON und schufen so dessen Atmosphärenkomponente. In der Zwischenzeit entwickelten Christian Reick und seine Kolleg*innen neue und biologisch aktivere Landmodelle und erarbeiteten zusammen mit dem DKRZ neue Methoden zur Kopplung der verschiedenen Komponenten.

Trotz der stetigen Fortschritte von ICON blieb das MPI-ESM für den Großteil des vergangenen Jahrzehnts das Arbeitspferd. Erst kürzlich integrierte eine Gruppe um Uwe Mikolajewicz erfolgreich ein interaktives Eisschildmodell in das MPI-ESM, um Klimaveränderungen seit dem Höhepunkt der letzten Eiszeit – also in den vergangenen 20 000 Jahren – zu simulieren.

Mit der Zeit begannen sich die Vorteile von ICON durchzusetzen. Dank eines vom MPI-M geleiteten nationalen Projekts arbeiteten Forschende in ganz Deutschland zusammen, um ICON auf einigen der größten Computer der Welt mit außergewöhnlich hoher räumlicher Auflösung über große und schließlich globale räumliche Bereiche laufen zu lassen. Dadurch konnten Klimaprozesse physikalischer dargestellt werden. So ließ sich die empirische Handarbeit vermeiden, die die Modellentwicklung jahrzehntelang beeinflusst hatte, und die Modellierungstätigkeit kam mit den wachsenden Beobachtungsbeiträgen des Instituts in Einklang.

Fast auf den Tag genau zum 50. Geburtstag des ikonischen „Blue Marble“-Fotos demonstrierte eine Gruppe unter der Leitung von Daniel Klocke die Fähigkeit von ICON, das vollständig gekoppelte Klimasystem auf einer Skala von nur einem Kilometer darzustellen: Dank der Unterstützung des Computerunternehmens NVIDIA bei der Visualisierung und des DKRZ bei der Bewältigung der Herausforderungen des Rechnens der nächsten Generation simulierten und visualisierten sie den Zustand der Erde zu dem Zeitpunkt, als das Foto aufgenommen wurde. Es handelte sich also im Grunde um eine Zwei-Tages-Vorhersage des Bildes, das sich den Astronauten bei ihrer Mission geboten haben musste. Die Ähnlichkeit der „echten“ Blue Marble und der Simulation war augenfällig. Die Wissenschaftler*innen hatten die Komplexität des Erdsystems gezügelt und den blauen Planeten in beeindruckender Detailtreue abgebildet.

Offene Fragen von gesellschaftlicher Relevanz

Neben der eindrucksvollen Demonstration dessen, was möglich ist, liegt die eigentliche Relevanz der hochauflösenden Simulationen in ihrem Vermögen, ein physikbasiertes Labor zu schaffen, in dem Forschende ihre Ideen testen und mit beobachtbaren Prozessen verknüpfen können. Heute erforschen die Wissenschaftler*innen am MPI-M verbleibende Rätsel der Klimaforschung, unter anderem in der Abteilung von Sarah Kang, die zuvor Professorin am Ulsan National Institute of Science and Technology in Südkorea war und die 2023 die Nachfolge von Martin Claußen antrat. Zu diesen Rätseln gehört beispielsweise die Frage, warum sich große Teile des östlichen Pazifiks entgegen der Prognosen abgekühlt haben, und wie dies mit Vorgängen in weit entfernten Regionen der Erde zusammenhängt. Weil oftmals kleinräumige Prozesse zwischen den großräumigen vermitteln, könnten hochauflösende Modelle Erkenntnisse liefern, die den eher statistischen Methoden früherer Modellgenerationen verwehrt blieben.

Auch die heute angesichts steigender globaler Temperaturen besonders relevante Frage, wie sich der Klimawandel auf regionaler Ebene auswirken wird, lässt sich nicht beantworten ohne ein tiefes Verständnis der physikalischen Prozesse auf der Kilometerskala. Dass diese nun in Erdsystemmodellen dargestellt werden können, liegt nicht nur an der Modellentwicklung, sondern abermals an den stark gewachsenen Rechenkapazitäten – und dem Umstand, dass der ICON-Code in vorausschauender Weise für die modernsten Hochleistungscomputer angepasst wurde. Ab Mai 2025 startet Europas schnellster Supercomputer JUPITER am Forschungszentrum Jülich in den Betrieb. In einem von Cathy Hohenegger geleiteten Projekt bereiten die MPI-M-Forschenden und ihre Partner Simulationen mit dem gekoppelten Erdsystemmodell ICON vor, welche eine Auflösung von nur einem Kilometer haben - und ein ganzes Jahr statt nur ein paar Tage umfassen.

Dabei geht das Institut auch der Frage nach, wie so gewonnene Informationen möglichst gut aufbereitet und breiten Nutzergruppen zur Verfügung gestellt werden können, etwa im Projekt „Destination Earth“ oder im Rahmen der globalen Initiative „Earth Virtualization Engines“ (EVE). Denn so viel ist aus den zurückliegenden Jahren klargeworden: Der Klimawandel ist überall auf der Welt bereits spürbar und verlangt sorgfältig geplante Anpassungsmaßnahmen. Die wachsende Zahl von klimabedingten Wetterextremen und die Krisen, die sie und weitere chronische Veränderungen verursachen, lassen nämlich einen Gedanken laut werden: Viel größer als die in das ikonische Foto hineininterpretierte Verletzlichkeit des blauen Planeten ist eigentlich die Verletzlichkeit seiner Bewohner*innen.

Weitere Informationen

Geschichte des Instituts

50 Jahre Klimaforschung - Veranstaltungen 2025

Kontakt

Prof. Dr. Jochem Marotzke

Geschäftsführender Direktor

Tel.: +49 (0)40 41173-440

jochem.marotzke@mpimet.mpg.de

Dr. Denise Müller-Dum

Referentin für PR und Kommunikation

Tel.: +49 (0)40 41173-387

denise.mueller-dum@mpimet.mpg.de